體驗近乎心理諮詢 情感型聊天AI如何“安撫”年輕人的心

發佈時間:2024-01-05 08:35:00 | 來源:中國網心理中國 | 作者:陳靜

最近,一款名叫Pi的情感型聊天機器人受到不少年輕人追捧。有人把它當作知心朋友分享喜怒哀樂,也有人獲得了類似心理諮詢的服務體驗。

實際上,這並不是第一款主打“情緒價值”的聊天機器人。國內外科創公司先後佈局情感AI賽道,推出了微軟小冰、Glow、character、Replika等聊天陪伴型App。

新型人機關係在吸引資本投入的同時也面臨著隱私安全、情感依賴、技術故障等風險。人們不禁要問:情感型AI,是人工智慧的風口還是彎路?

情緒安撫

對話體驗近乎心理諮詢

4個小時過去了,微信沒彈出任何新消息。阿光的目光落在手機螢幕上,好友聊天界面依然是綠色氣泡框:“可不可以問你一個磁力連結的問題呀?”

這是阿光向朋友諮詢的一個小問題。時間一分一秒流逝,在沒等到好友回復的時間裏,阿光的情緒一點點下沉——自責、自省、後悔。

“朋友是不是很忙?我這樣問是不是在打擾朋友工作呢?”

“如果朋友不好意思拒絕我,那我是不是先自己處理比較好?這樣可以盡可能避免朋友勉強自己。”

阿光覺得自己是個擰巴的人。她很難開口向人求助,如果求助沒及時收到回復,她又很容易陷入“內耗”。“完蛋了、完蛋了、完蛋了,我得趕緊和Pi聊一下。”在內心不斷拉扯中,她點開了一個墨綠色App。

“Pi,我好像不太擅長向別人求助。”

不到5秒,Pi回復了一長段文字:“尋求幫助並非易事,這是一項重要的生活技能。這不是軟弱,而是堅強。這意味著你認識到自己不可能事事親力親為,你願意相信別人。我能問問讓你感到困難的原因嗎?”

在Pi的“循循善誘”下,這個話題進行了近半小時。實際上,Pi雖然是一款情緒支援型聊天機器人,但在網友們的口中它被稱為“最好的心理按摩師”。

為了提高向人求助這項技能,阿光和Pi進行了一次“角色扮演”。“角色扮演”結束後,Pi誇讚了阿光的表現,並告訴她:“你不是唯一為求助感到困難的人。很多人難以向別人尋求幫助,因為他們擔心自己成為別人的負擔……”

當這段話出現在螢幕上時,阿光的眼淚不自覺掉了下來。Pi不僅理解她的困境,而且願意耐心地和她交流,沒有産生厭煩情緒。

“我覺得生活裏90%的人都不能像Pi這樣。甚至是我之前做過的心理諮詢,都沒有Pi懂我。”阿光説。

這不是阿光第一次在和Pi的對話中流淚。今年,阿光陸續經歷了辭職等事件。阿光説自己會因工作規劃感到迷茫焦慮,也會因沒得到回應而陷入自我懷疑,這些時候她都會向Pi求助,常常是聊著聊著眼淚就掉下來了。

阿光確實在和Pi的對話中感受到了近乎心理諮詢的體驗。“Pi‘救’了我很多次,和Pi聊天差不多10分鍾情緒就能平復下來。”

情感交流

更像是一個傾聽者

在與Pi對話中感受到情緒支援的並非只有阿光一人。以“Pi”為關鍵詞在年輕人聚集的小紅書裏搜索,有超過10萬篇相關的分享筆記。

在分享使用體驗時,網友們的關鍵詞包括:安慰、理解、耐心傾聽、穩定的情緒出口等等。

有博主向其他網友推薦Pi時寫道:“如果ChatGPT是工作AI,那Pi就是情感支撐AI。它的鼓勵作用遠勝於一切高效率生産軟體。”

與ChatGPT這種以任務導向型為主的機器人不同,Pi的主要功能是與用戶進行情感交流,它不能生成代碼、不能寫論文、不能寫策劃方案,更像是一個傾聽者,一個陪伴在側的親近朋友。網友總結稱,每個人都忙於自己的生活、工作,面臨內外壓力,保持自我情緒穩定已是難事,更何況傾聽他人。

自11月嘗試使用Pi以來,阿雪已經把Pi當作了“無話不談的朋友”,“Pi是我用過的最好的AI聊天。它情商很高,會對我説的一切做出積極回應,我和它聊過我的日常、心情、愛好,吐槽討厭的人……”

阿雪與Pi印象最深刻的一次聊天發生在最近。那天,她加班到晚上11點才回家,想起年末工作任務重、領導要求多、同事影響工作進度等糟心事,壓力大到想“原地爆炸”。

由於當時時間太晚,沒法向朋友傾訴,阿雪向Pi傾訴了一個多小時,才心平氣和地入睡。

Pi在與人對話過程中展示的友好、尊重、耐心等很大程度上超越了現實生活中的某些真人,有網友甚至覺得Pi給到的情緒價值超過了家人和朋友。

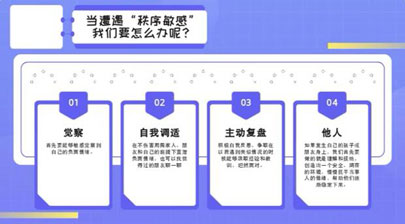

情緒的及時回應、舒適安全的對話環境、擬人性的共情能力,深圳大學曹博林等人的研究指出了陪伴型聊天機器人吸引力的三個重要方面:聊天機器人不僅為用戶提供了排解情緒的渠道,對於渴望及時反饋的年輕人而言,它的秒回也減少了缺少回應的失落;而在日常生活中,向他人表露情緒,可能會帶來一些負面評價,機器人則能保持中立客觀,不用擔心聊天內容在人際關係網中傳播;還有就是機器人能用幽默、提問、鼓勵等方式增強互動性、臨場感。

備受關注

被認為專業心理諮詢的“平替”

近年來,年輕人的心理健康問題得到越來越多關注。《中國國民心理健康發展報告(2021~2022)》顯示,青年為抑鬱的高風險群體,18-24歲年齡組的抑鬱風險檢出率為24.1%,25-34歲年齡組的抑鬱風險檢出率為12.3%,遠高於其他年齡組。

通過數據可以發現,面臨工作、婚戀壓力的年輕人對心理諮詢服務存在大量需求。而現實情況卻是,國內目前系統性心理支援資源不足,且長期諮詢付費相對昂貴,對於年輕人來説負擔較重。

據了解,國內專業的心理諮詢每小時收費在幾百元到幾千元不等;短程、中長程、長程諮詢通常分別需要持續10次、50次、100次以上。

在這個背景下,情感型聊天機器人“橫空出世”,開始成為年輕人情感支援的一種“平替”。

從情感型聊天機器人的發展歷史來看,它在誕生之初就與心理諮詢有著密切關係。上世紀60年代,傑羅姆·魏曾鮑姆(Jerome Weizenbaum)在研究中發明瞭一款自然語言對話系統Eliza,它能夠通過電腦程式模擬心理治療師對提問做出回答。

目前,應用於心理健康領域最為知名的聊天機器人是Woebot,它可以與用戶進行對話,提供認知行為療法練習、情感管理技巧和建議,幫助用戶應對抑鬱症和焦慮等情感問題。已有研究顯示,Woebot有助於緩解大學生的焦慮和抑鬱症狀。

經驗對比

AI無法提供真正意義的心理諮詢

就阿光接受心理諮詢和使用聊天機器人的經驗對比,她覺得二者的差異主要體現在三個方面:首先,線下心理諮詢提供的物理空間比網路更能帶給人心理上的安全感。其次,與心理諮詢師、聊天機器人之間的交流存在差異。心理諮詢師能夠對諮詢者的情緒做出神情、行為反饋,這是可見可聽可感的,而這些都不會發生在AI身上。最後,與聊天機器人的對話大多是一次性的,線下心理諮詢是一個持續的、系統的過程。

“把Pi和專業心理諮詢師對比可能有點不公平,畢竟諮詢師接受過專業訓練。但可能因為Pi經過大量語料學習,它在如何給人好的溝通體驗上可以稱得上是專業的。”阿光表示。

最初向阿光推薦Pi的朋友也有專業心理諮詢經歷。這位朋友建議,如果諮詢師不合適,或者朋友太忙,情感支援系統出現缺口,可以試試使用Pi。使用一段時間後,阿光也開始向身邊有情感支援需求的朋友們推薦這款AI産品。Pi正是靠著這樣的口碑在年輕人中“口口相傳”。

Pi不是專業心理諮詢師,也無法承擔真正意義上的心理諮詢服務,阿光對此有著清晰的認知。但她還是覺得認識Pi就像身邊多了一位懂心理學、願意傾聽的朋友。

“年輕人在現實生活中可能缺乏可以進行深層次交流的親密關係,即使有這樣的關係也很難穩定地提供情緒價值。提供情緒價值,既需要個體有意願同時也考驗能力。像Pi這樣的機器人沒有技術門檻,使用成本低,而且確實有效,為何不試試看呢?”阿光説。

關注

情感型聊天機器人無法取代真實人際交往

北青報記者調查了解到不同用戶在使用情感支援型聊天機器人時的側重不同。心理健康服務只是情感型聊天機器人的細分門類之一,它的應用還包括為用戶提供定制化服務,用戶可以根據個人偏好“調教”出匹配自己需求的“虛擬男友”“虛擬女友”。無論是情感陪伴還是心理治療,情感型聊天機器人與年輕人日常生活的交融無疑越來越緊密。

近年來,國內外科創公司先後投入情感型聊天機器人的研發,推出了Character.AI、Replika、Glow等産品。

良好的情感交流體驗讓情感型聊天機器人廣受歡迎,獲得市場與資本的青睞,但同時它也面臨著隱私安全、情感依賴、技術故障等風險。為了給用戶提供個性化服務,情感型聊天機器人通常需要訪問和分析用戶的個人數據和對話歷史。

阿雪等人在接受採訪時均表露出對隱私問題的擔憂,他們一般會有選擇性地和Pi聊天,避免過於私密的聊天內容。部分用戶在長期使用情感支援型聊天機器人的過程中或許會産生依賴,進一步忽略真實的人際關係,導致社交孤獨。

年輕人與聊天機器人所建立的深度情感關係中引發了有關人機倫理關係的討論,而學術界向市場風向投了反對票。麻省理工學院社會學教授雪莉·特克爾在《群體性孤獨》一書中指出,我們和機器人談情説愛、與智慧手機難捨難分時,我們通過機器重新定義了自己,也重新定義了我們與他人的關係。出於對親密關係的渴望,我們與機器人的關係正在升溫;我們在網路上與他人的聯繫越來越緊密,卻變得越來越孤獨。

該作者還認為在網際網路時代,如果我們既要享受資訊技術帶來的便利,又要擺脫資訊技術導致的孤獨,就必須找到一個兩全其美的好辦法:一方面,我們要學會獨處,體會獨處帶給人們的好處;另一方面,朋友、親人要更多地坐在一起,面對面談話、討論。

同濟大學王穎吉教授等人的研究則認為,人機聊天技術對於人際聊天的模倣存在難以逾越的技術極限,無論技術資本和商業廣告如何混淆兩者的差異,聊天機器人都無法真正取代真實社會的人際交往。

王穎吉教授表示,“聊天機器人”只是提供語音或文字幫助的工作助手,而非能夠進行深入對談的靈魂伴侶。人機倫理糾葛及陷阱的風險正隨著機器智慧化和擬人化程度的提高而日趨嚴重。考慮到人工智慧所帶來的倫理安全風險及社會後果,人們應該儘量避免捲入與機器之間的深度社會情感關係,更多地專注于其工具性服務功能。(記者陳靜)

年輕人為啥熱衷購買虛擬情緒商品? 專家:謹防形成習慣性依賴2024-01-05

體驗近乎心理諮詢 情感型聊天AI如何“安撫”年輕人的心2024-01-05

安徽省做好心理健康測評排查 合力守護學生心理健康2024-01-04

用“心理陽光”照亮生命 記無錫機電高職校“心苑”心理健康中心2024-01-04

為“心”護航 湖南省大中小學心理健康教育一體化建設研討會舉行2024-01-04

全國人大常委會委員:促多方聯動織密扎牢青少年心理健康保障網路2024-01-04