10月30日,百川智慧發佈Baichuan2-192K大模型。其上下文窗口長度高達192K,能夠處理約35萬個漢字,是Claude2(支援100K上下文窗口,實測約8萬字)的 4.4倍,更是 GPT-4(支援32K上下文窗口,實測約 2.5萬字)的14倍。

上下文窗口長度是大模型的核心技術之一,通過更大的上下文窗口,模型能夠結合更多上下文內容獲得更豐富的語義資訊,更好的捕捉上下文的相關性、消除歧義,進而更加準確、流暢的生成內容,提升模型能力。

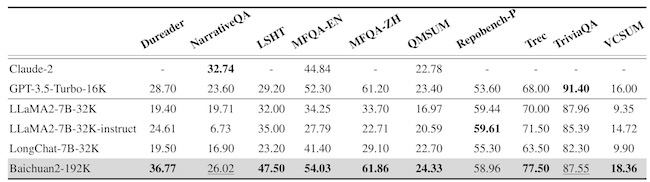

Baichuan2-192K在Dureader、NarrativeQA、LSHT、TriviaQA等10項中英文長文本問答、摘要的評測集上表現優異,有7項取得SOTA。

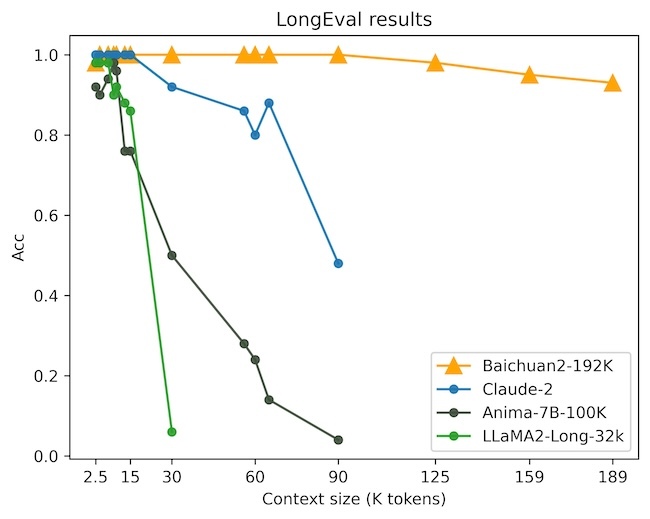

此外,LongEval的評測結果顯示,在窗口長度超過100K後Baichuan2-192K依然能夠保持強勁的性能,而其他開源或者商用模型在窗口增長後效果都出現了近乎直線下降的情況。Claude2也不例外,在窗口長度超過80K後整體效果下降非常嚴重。

(LongEval是加州大學伯克利分校聯合其他高校發佈的針對長窗口模型的評測榜單,主要用來衡量模型對長窗口內容的記憶和理解能力)

擴大上下文窗口能有效提升大模型性能是人工智慧行業的共識,但是超長上下文窗口意味著更高的算力需求和更大的顯存壓力。

目前,業內有很多提升上下文窗口長度的方式,包括滑動窗口、降採樣、小模型等。這些方式雖然能提升上下文窗口長度,但對模型性能均有不同程度的損害,換言之都是通過犧牲模型其他方面的性能來換取更長的上下文窗口。

而本次百川發佈的Baichuan2-192K通過演算法和工程的極致優化,實現了窗口長度和模型性能之間的平衡,做到了窗口長度和模型性能的同步提升。

今年9月25日,百川智慧已開放了Baichuan2的API介面,正式進軍企業級市場,開啟商業化進程。此次Baichuan2-192K將以API調用和私有化部署的方式提供給企業用戶,目前百川智慧已經啟動Baichuan2-192K的API內測,開放給法律、媒體、金融等行業的核心合作夥伴,不久後還將全面開放。

(責任編輯:譚夢桐)