“紫東太初”全模態大模型發佈 探索可自主進化的通用人工智慧

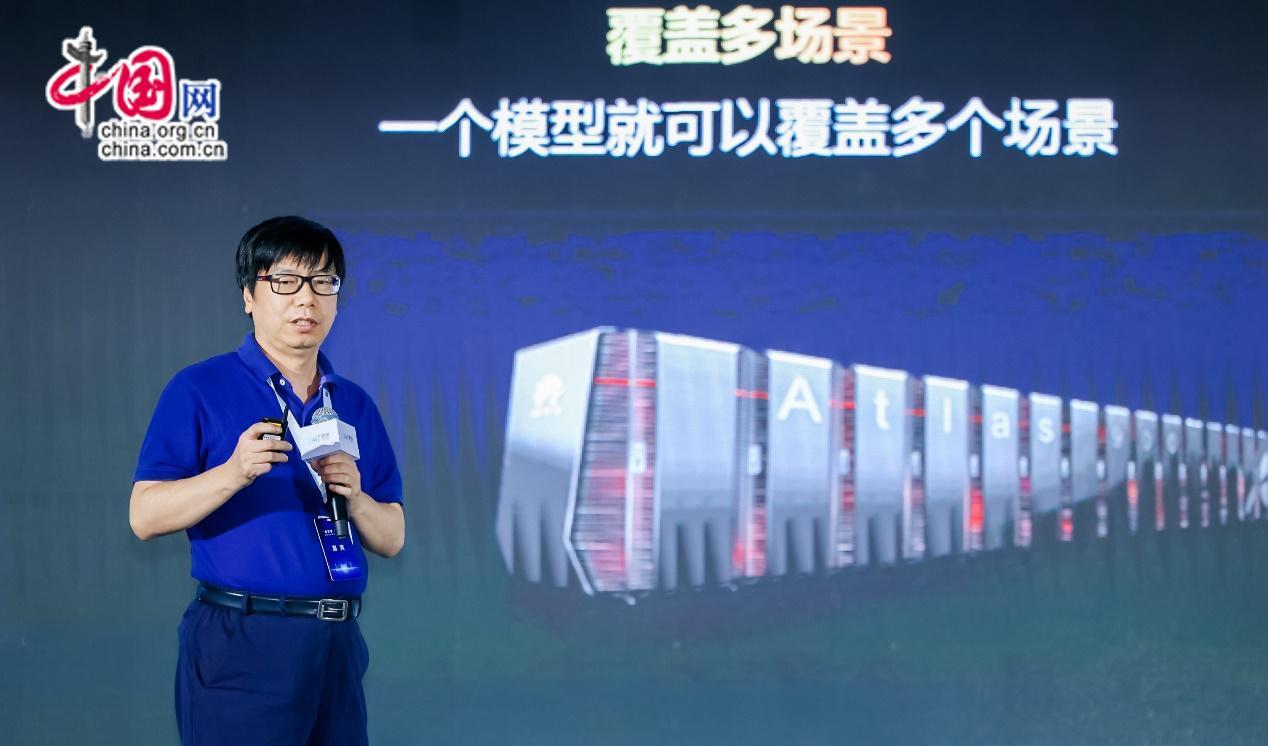

中國網/中國發展門戶網訊 6月16日,在人工智慧框架生態峰會2023上,中國科學院自動化研究所所長徐波正式發佈“紫東太初”全模態大模型。

圖為中國科學院自動化研究所所長徐波發佈“紫東太初”全模態大模型。

“紫東太初”全模態大模型是在千億參數多模態大模型“紫東太初”1.0基礎上升級打造的2.0版本,在語音、圖像和文本三模態的基礎上,加入視頻、傳感信號、3D點雲等模態數據,研究突破了認知增強的多模態關聯等關鍵技術,具備全模態理解能力、生成能力和關聯能力,面向數字經濟時代加速通用人工智慧的實現。

會上,徐波首次對外實時展示了大模型在音樂理解與生成、三維場景導航、信號理解、多模態對話等方面的全新功能,並邀請現場觀眾與大模型即時互動。“紫東太初”全模態認知大模型不僅可以透過《月光曲》暢談貝多芬的故事,也可以在三維場景裏實現精準定位,還能夠通過圖像與聲音的結合完成場景分析,在現場獲得了熱烈反響。

圖為中國科學院自動化研究所所長徐波發佈“紫東太初”全模態大模型。

從多模態到全模態的持續探索

人類在認知世界時,往往同時涉及語音、圖像、文字等資訊。機器需要實現更高水準的智慧,就需要像人一樣,發展貫通圖、文、音等更多模態的大模型。自2019年起,中國科學院自動化研究所(以下簡稱“自動化所”)即堅持以“圖-音-文”多模態技術為核心,確立多模態大模型佈局,整合所內圖像、文本、語音等研究方向的優勢資源開展集團式攻關,于2021年9月成功打造“紫東太初”1.0多模態大模型。“紫東太初”1.0助推人工智慧從“一專一能”邁向“多專多能”,向發展通用人工智慧邁出了堅實的第一步。

以此為基礎,“紫東太初”大模型的多模態探索仍在持續深入。邁入數字經濟時代,數據的範疇不斷拓寬,不僅包含人類自身産生的語音、圖像、文字等數據,還有機器産生的大量結構和和非結構化數據。針對新需求與新趨勢,“紫東太初”2.0在語音、圖像和文本之外,加入了視頻、傳感信號、3D點雲等更多模態,從技術架構上實現了結構化和非結構化數據的全模態開放式接入;突破了能對資訊進行充分理解和靈活生成的多模態分組認知編解碼技術,能融合多個任務的認知增強多模態關聯技術等,大模型多模態認知能力大幅提升。

“紫東太初”2.0可以理解三維場景、傳感信號等數字物聯時代的重要資訊,完成了音樂、圖片和視頻等數據之間的跨模態對齊,能夠處理音樂視頻分析、三維導航等多模態關聯應用需求,並可實現音樂、視頻等多模態內容理解和生成。從1.0到2.0,“紫東太初”大模型打通了感知、認知乃至決策的交互屏障,使人工智慧進一步感知世界、認知世界,從而延伸出更加強大的通用能力

圖為中國科學院自動化研究所所長徐波發佈“紫東太初”全模態大模型。

打造全棧國産化通用人工智慧底座

“紫東太初”2.0以自動化所自研演算法為核心,以昇騰AI硬體及昇思MindSpore AI框架為基礎,依託武漢人工智慧計算中心算力支援,著力打造全棧國産化通用人工智慧底座。長期以來,強大的算力支撐是約束我國人工智慧發展的瓶頸之一,以“紫東太初”大模型為領頭雁開展的創新實踐將有力推動國産基礎軟硬體與大模型技術的適配,協同構建我國通用人工智慧自主可控發展生態。

全模態賦能,産業應用前景廣闊

目前,“紫東太初”大模型已展現出廣闊的産業應用前景,在神經外科手術導航、短視頻內容審核、法律諮詢、醫療多模態鑒別診斷、交通違規圖像研讀等領域開始了一系列引領性、示範性應用。

在醫療場景,“紫東太初”大模型部署于神經外科機器人MicroNeuro,可實現在術中實時融合視覺、觸覺等多模態資訊,協助醫生對手術場景進行實時推理判斷。同時與北京協和醫院合作,利用“紫東太初”具備的較強邏輯推理能力,嘗試在人類罕見病診療這個挑戰性醫學領域有所突破。

徐波表示,自動化所以“紫東太初”大模型為基礎,持續探索與類腦智慧、博弈智慧等技術路徑的相互融合,最終實現可自主進化的通用人工智慧。並將探索在更多領域發揮賦能價值,為促進我國數字經濟快速發展貢獻力量。