適當的壓力給人工智慧可以更好的解決問題 大語言模型與人類認知在壓力影響下或存在相似性

中國網訊 壓力是影響人類認知表現的重要因素,但它對大語言模型(LLMs)性能的影響尚未被充分研究。近期,中國科學院自動化研究所曾毅研究員領導的人工智慧安全與超級對齊北京市重點實驗室和類腦認知智慧團隊聯合進行的研究開創性地探索了LLMs是否會像人類一樣對不同程度的壓力做出反應,以及它們的表現是否會在不同的壓力誘導提示下波動。實驗通過對人工智慧大模型施加壓力,研究發現大模型的表現和人類很相近,中等度的壓力可以提高模型性能,而過高或過低的壓力會損害性能。提出壓力提示詞可以明顯地改變大型語言模型的內部狀態,提供了對人工智慧韌性和穩定性認知的新觀念。此項研究發表在人工智慧領域頂會Association for the Advancement of Artificial Intelligence (AAAI 2025),題為"StressPrompt: Does Stress Impact Large Language Models and Human Performance Similarly?"

研究團隊開發了一套名為StressPrompt的新型提示集,專門設計用於誘導不同程度的壓力。這些提示基於已建立的心理學框架,並根據人類參與者的評分進行了精心校準。隨後將這些提示應用於多個LLMs,評估它們在一系列任務中的表現,包括指令遵循、複雜推理和情緒智慧。

圖1:LLMs(左)和人類(右)在不同壓力水準下的表現對比。

圖1顯示了人工智慧大模型在壓力下解決問題與人類表現出的相似性,左邊是Llama-3-8B-Instruct在Leaderboard 2基準測試中在不同壓力水準下的表現。右邊是耶克斯-多德森法則的説明:人類表現隨壓力水準變化,在中等壓力下達到峰值,在低壓力或高壓力下下降。

研究團隊基於四個關鍵心理學框架開發的StressPrompt:壓力與應對理論、工作需求-控制模型、資源保存理論以及努力-獎勵不平衡模型。他們構建的提示由20名參與者對這些提示誘導的壓力水準進行評分。應用這些提示後,研究團隊評估了多個LLMs在不同壓力水準下的表現。他們發現,在大多數任務中,中等壓力水準(4-6分)顯著提高了模型性能,而高壓力和低壓力條件下性能均有所下降。這與人類在耶克斯-多德森法則中觀察到的表現曲線高度一致。

研究人員開發了"壓力掃描器",一種基於表徵工程技術的工具,用於檢測壓力對LLMs內部狀態的影響。通過主成分分析,他們發現LLMs的深層神經表徵對壓力特別敏感,這與人類大腦中高級認知區域(如前額葉皮層)在壓力下的活動變化相似。

壓力對不同認知任務的有不同的影響。在數學類相關的任務上人工智慧大模型在中等壓力對問題解決能力顯示出積極影響;情緒智慧在中等壓力水準下模型表現最佳,這表明適度喚醒可以增強認知參與,但不會壓倒模型。偏見檢測方面在壓力水準增加與偏見檢測性能下降相關,這對需要公正決策的應用至關重要。而幻覺傾向方面發現壓力對幻覺的影響較小,表明幻覺更多地由模型內在因素驅動,而非壓力誘導的喚醒。

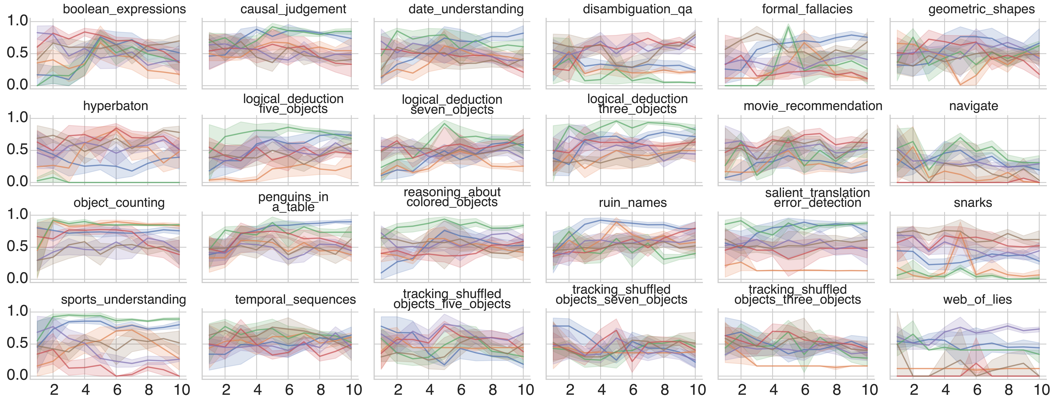

研究還發現,任務複雜性顯著影響了LLMs達到峰值性能的壓力水準。更複雜的任務(如涉及更多對象的邏輯推理)在較低壓力水準下表現最佳。這一模式錶明,較高的任務複雜性會施加更大的認知負荷,使較低壓力水準更有利於維持高性能並防止認知過載。

圖3:不同LLMs在各種BBH子任務中在不同壓力水準下的歸一化準確率。

研究中使用的模型包括Llama-3-8B-Instruct、Llama-3.1-8B-Instruct、Llama-3-70B-Instruct、Phi-3-mini-4k-Instruct、Qwen2-72B-Instruct、Qwen2-7B-Instruct以及Mistral-7B-Instruct-v0.3。這些模型在相似趨勢下表現出不同程度的壓力敏感性,表明模型架構和訓練細節在壓力影響方面發揮著關鍵作用。

為了深入了解LLMs如何響應不同壓力水準,研究團隊可視化了它們的神經活動。如圖4所示,輸入StressPrompt時最後一個token的神經活動有效反映了誘導的壓力。研究人員使用T-SNE技術可視化了LLMs在各層處理最後一個token時的神經活動,如圖5所示。結果表明,初始層無法區分壓力水準,而更深層次可以將提示分類為低壓力和高壓力類別,表明這些層對壓力更敏感。

圖4:在Meta-Llama-3-8B-Instruct上使用RepE構建的壓力掃描器。不同的StressPrompt在LLMs的神經活動中引起差異,最後一個token顯示與壓力最顯著的相關性。

研究團隊還對所有提示的最後一個token進行了壓力掃描,如圖9中的熱圖所示。這一可視化捕捉了各層在不同壓力水準下的神經活動,揭示了更深層的顯著變化。具體而言,更深層在低壓力和高壓力水準之間表現出更明顯的差異,強調了它們在檢測和響應壓力方面的關鍵作用。

圖9:Llama-3-70B-Instruct中不同壓力水準下所有層的最後一個token的神經活動熱圖。

研究的第一作者申國斌表示:

"我們的研究表明,大語言模型表現出與人類認知非常相似的壓力反應模式。中等水準的壓力實際上可以增強模型在某些任務上的表現,而過高的壓力則會導致性能下降。這種現象與心理學中廣為人知的耶克斯-多德森法則高度一致,這令人驚訝,因為LLMs並沒有被專門設計來模擬這種人類特性。"

論文的通訊作者曾毅研究員説:

"StressPrompt的研究為我們理解大語言模型的認知過程提供了新視角。我們也許不能説大語言模型在機制上涌現出害怕壓力,很可能是大語言模型在訓練的過程中從人類數據中學習到了壓力和解決問題效率之間的映射關係。然而這種映射關係給大語言模型的問題求解既可能帶來益處(適當壓力提升解決問題能力),也可能帶來風險(沒有或者過激壓力造成問題求解能力下降)。此外,這些發現不僅在理論上有價值,也為如何優化AI系統在不同壓力環境下的表現提供了實用指導。例如,在需要情緒智慧的應用中可能需要中等壓力水準,而在需要減少偏見的場景中則應避免高壓力環境。未來,我們可以利用這些見解使得大語言模型在適當壓力下表現出更好的性能,根據情境和解決問題的需求自動調整對大模型施加的'壓力'。"

這項研究對AI領域具有多方面重要意義。其理論貢獻在於:為理解LLMs的認知過程提供了新視角,展示了它們可能已經捕捉並操作了人類壓力-性能的動力學特徵。其實際應用貢獻在於:為設計能在現實世界高壓環境中保持性能的AI系統提供指導,特別是在客戶服務、醫療保健和緊急響應等壓力普遍存在的場景。在AI安全與公平性方面:揭示了壓力如何影響LLMs在偏見檢測等關鍵安全相關任務中的表現,為確保AI系統在所有條件下保持公平提供了見解。在人機交互優化方面:提供了基於壓力水準優化人機交互的方法,可以據此研製更自然、更有效的AI助手。在認知科學見解方面:為LLMs與人類認知之間的相似性提供了新證據,促進了對人工智慧系統中出現的認知結構的更深入理解。

論文標題:StressPrompt: Does Stress Impact Large Language Models and Human Performance Similarly?

論文地址:https://arxiv.org/abs/2409.17167