Yandex研發人員開發壓縮大型語言模型新方法,可將AI部署成本降低多達 8 倍

發佈時間:2024-08-01 16:35:38 | 來源:中國網科學 | 作者: | 責任編輯:王琦

Yandex研發團隊與來自IST Austria、NeuralMagic和KAUST的研究人員合作,開發了兩種針對大型語言模型的創新壓縮方法:語言模型的加性量化 (AQLM)和 PV-Tuning。這兩種方法結合使用時,可將模型大小減少多達8倍,同時保持95%的響應品質。這些方法旨在優化資源,並提高運作大型語言模型的效率。詳細介紹此方法的研究文章已在近期在奧地利維也納舉行的國際機器學習大會 (ICML)上發表。

AQLM和 PV的主要特點

在消費類硬體上部署大型語言模型是具有挑戰性的,因為模型大小和計算效率之間存在固有的權衡。量化等壓縮方法提供了部分解決方案,但往往會影響模型性能。

AQLM利用傳統上用於資訊檢索的加性量化來進行大型語言模型的壓縮,可將每個模型參數的比特數減少到2-3比特,該方法可在極端壓縮的情況下保持甚至提高模型的準確性,從而使得在家用電腦等日常設備上部署大型語言模型成為可能。這也顯著減少了記憶體消耗。AQLM的關鍵創新包括權重矩陣的學習加性量化,以適應輸入的可變性,以及對跨層塊的碼本參數進行聯合優化。這種雙重策略使 AQLM能夠超越其他壓縮技術,在該領域樹立了新的基準。

PV- Tuning是一個與表示無關的框架,它概括並改進了現有的微調策略,可解決模型壓縮過程中可能出現的錯誤。PV-Tuning在有限情況下提供收斂保證,並且在 Llama和 Mistral等高性能模型上用於1-2位向量量化時,其性能已被證明優於以前的方法。通過利用 PV-Tuning,研究人員首次實現了 Llama 2模型每個參數 2比特的帕累托最優量化。

當AQLM和 PV-Tuning結合使用時,可獲得最佳結果——即使在有限的計算資源下,也能提供高品質響應的緊湊模型。

方法評估與認可

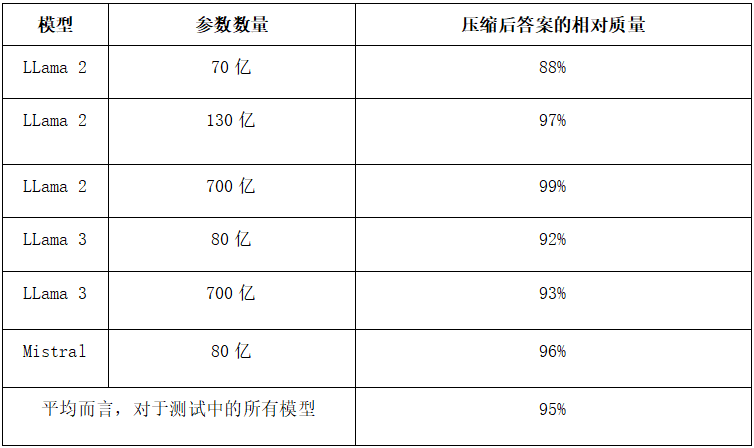

研發團隊使用LLama 2、Llama 3、Mistral等流行的開源模型,對這些方法的有效性進行了嚴格評估。研究人員通過對這些大型語言模型進行壓縮,並根據英語基準(WikiText2和 C4)評估答案品質,在模型壓縮8倍的情況下,仍獲得了令人印象深刻的95%的答案品質。

*測試中答案的平均準確度越接近原始模型,新方法在保持答案品質方面就越好。上圖的數字顯示了兩種方法的綜合結果,模型平均壓縮了 8倍。

AQLM的實用性還通過其在 GPU和 CPU架構上的實現得到了證明,使其適用於實際應用。比較分析表明,AQLM可以在不影響模型性能的情況下實現極限壓縮,這一點可以從其在零樣本任務中的模型複雜度和準確性等指標上取得的優異結果得到證實。

誰可以從 AQLM和 PV-Tuning中受益

新方法為參與開發和部署專有語言模型和開源大語言模型的公司節省了大量資源。例如,具有 130億參數的 Llama 2模型在壓縮後,現在只需1個 GPU(原先需要4個)就可以運作,硬體成本降低高達8倍。這意味著初創公司、個人研究人員和大語言模型愛好者可以在他們日常使用的電腦上運作 LLama等高級大語言模型。

探索新的大語言模型應用

AQLM和 PV-Tuning使得在計算資源有限的設備上離線部署模型成為可能,從而為智慧手機、智慧音箱等提供了新的使用場景。通過整合先進的大語言模型,用戶可以使用文本和圖像生成、語音輔助、個性化推薦,甚至實時語言翻譯,而無需激活網際網路連接。

此外,因為所需的計算更少,使用這些方法壓縮的模型運作速度可提高多達4倍。

實施與訪問

全球的開發人員和研究人員已可以使用 AQLM和 PV-Tuning,這兩種大型語言模型壓縮方法都可在GitHub上獲取。作者提供的演示材料為各種應用提供了有效的壓縮大語言模型指導。此外,開發者還可以下載已經使用這些方法壓縮過的流行開源模型。

國際機器學習大會亮點

Yandex Research發表的一篇關於 AQLM壓縮方法的科學文章已在全球久負盛名的機器學習會議之一國際機器學習大會(ICML)上發表。該文章由Yandex研發團隊與 IST Austria的研究人員和人工智慧初創公司Neural Magic的專家共同撰寫,標誌著大語言模型壓縮技術的重大進步。