隨著技術的不斷進步,人工智慧(AI)已經開始在視頻製作領域扮演越來越關鍵的角色。小鵬汽車的AI研究團隊近日推出的“任意物體于任意場景”(Anything in Any Scene)技術引發了業界廣泛關注。該技術通過先進的生成式人工智慧(AiGC)演算法,能夠將任意物體無縫整合進動態視頻中,創造出極致真實的視覺效果。參與該項研發工作的小鵬汽車AI研究員Xiaoyin Zheng先生深入解讀了該技術及其背後的願景與初衷。

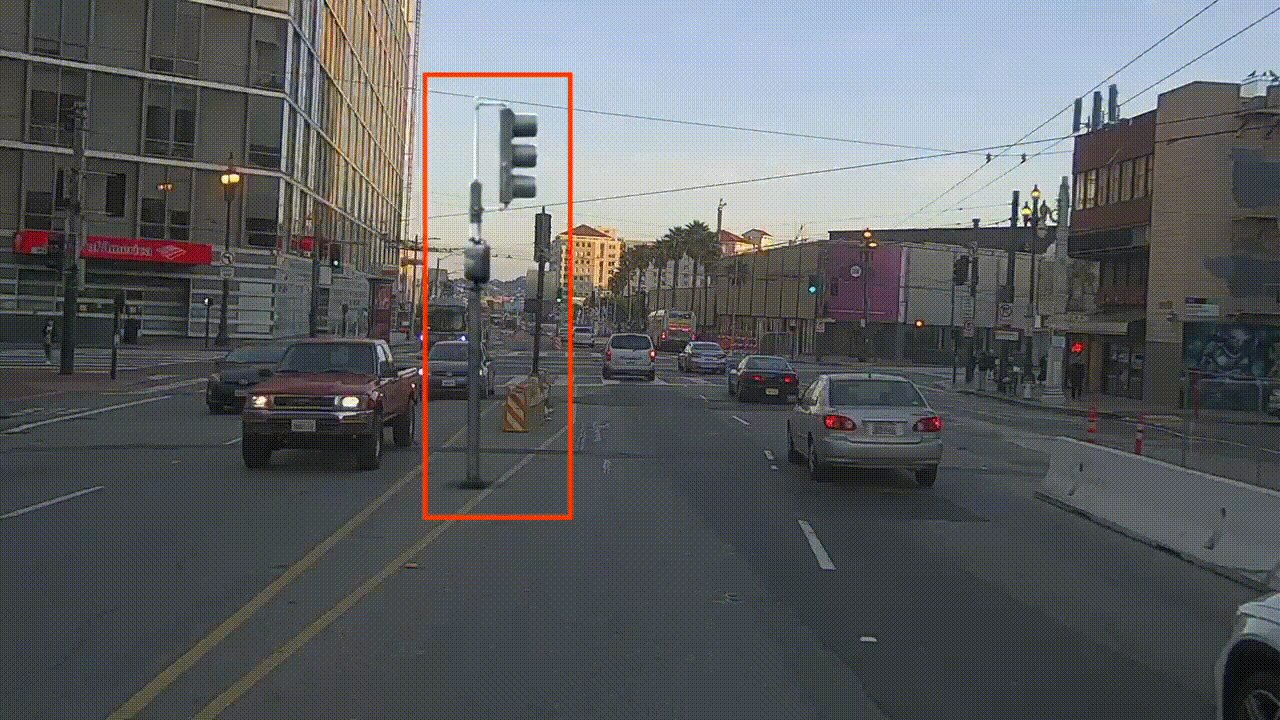

“利用我們研發的Anything in Any Scene技術,用戶能在任意的視頻場景中,插入任意物品,並且達到以假亂真的程度”。為證實所言非虛,Xiaoyin Zheng展示了應用此技術製作的視頻,並邀請記者嘗試識別其中後期插入的物體。場景包括室外道路、夜間道路和室內場景。記者經多次觀看後,也難以辨識異樣,直至Xiaoyin Zheng揭示紅綠燈、垃圾桶和頭盔等物體竟然均為後期插入。

Xiaoyin Zheng隨後介紹了這項技術的架構細節。“相比以往的演算法框架,例如DoveNet、PHDiffusion,Anything in Any Scene呈現的效果更加逼真,這得益於我們架構中的三個主要模組,分別保證了物體擺放位置的真實性,光照的真實性,和色調的真實性。在確保物體在視頻中正確放置的過程裏,我們的技術框架首先確定相機在視頻中的世界坐標係位置,將其作為插入物體的基準點。接著,通過分析相機的內參和方位,精確計算出物體三維模型在各個視頻幀裏的具體位置。我們還使用了語義分割模型預測物體的掩碼,避免插入物體被其他物體遮擋。為了使物體在視頻中保持穩定,我們會預測視頻連續幀之間的光流來跟蹤物體的運動軌跡,並減少物體在連續幀上的投影差異,從而實現物體隨著攝影角度變化時的平滑移動。為了保證物體光照的真實性,我們還會根據視頻流中的天空部分畫面,推理出主光源的高光和環境光漫反射這兩種光源的HDR分佈,並將此HDR分佈送給渲染管線中,這樣就可以連同物體的陰影一併渲染出來,生成逼真的光照效果。最後,我們會對物體做一個style transfer(風格變換),使其更逼近目標視頻流的整體色調,進一步提高整個視頻的逼真程度。”

對於外界關於“任意物體于任意場景”技術是否僅用於製作虛假視頻的質疑,Xiaoyin Zheng給出了詳細的回答。他解釋説:“我們開發這項技術的初衷,實際上是為了在數據層面,促進自動駕駛技術的發展。在自動駕駛系統的訓練階段,通常需要收集大量的實際駕駛數據。然而,某些罕見但重要的情形,如道路上的事故車輛、特種車輛、障礙物、行人意外穿越等,往往難以在日常環境中收集到足夠的數據樣本。若能通過AiGC技術創造出極為逼真的場景數據,就能夠以極為低廉的成本,為自動駕駛系統提供持續的、高品質的訓練‘養料’。”他進一步闡釋,“然而,這項技術的應用遠不止於此。正如其名稱‘任意物體于任意場景’所暗示的,它賦予了用戶在任何視頻場景中插入任何物體的能力,這極大地拓展了視頻編輯的可能性。無論是在AI視頻創作領域,還是在增強現實(AR)與虛擬現實(VR)等新興領域,這項技術都有著廣闊的應用前景。”

在討論Anything in Any Scene與近期大火的OpenAI SORA之間的關係時,Xiaoyin Zheng認為,這兩種技術互相補充而非直接競爭。他指出,在視頻創作過程中,SORA和‘任意物體于任意場景’技術都將是重要的工具。“如果我要從頭開始利用AI創造一段視頻,我會首先用SORA來構建整個場景,接著使用‘任意物體于任意場景’對視頻中對物體細節有高精度要求的部分進行細緻編輯。通常情況下,SORA負責將視頻創作從0到90%,而‘任意物體于任意場景’負責完成剩下的,也是極具難度的10%。有了Anything in Any Scene,使用SORA的創作者可以説是錦上添花,將創作提升到全新的高度。”

展望未來,隨著技術的持續發展和完善,Anything in Any Thing與SORA等先進AI工具的結合使用,將不僅為視頻創作帶來革命性的變革,同時也將在自動駕駛、虛擬現實等多個領域開拓出更廣闊的應用空間。這些技術的發展和應用,預示著我們正邁向一個更加智慧、更加多元的新時代。人工智慧的邊界將不斷被拓展,創新的火花在不同領域間碰撞,引領我們走向更加精彩的未來。